Lovecraft et le cauchemar cosmique

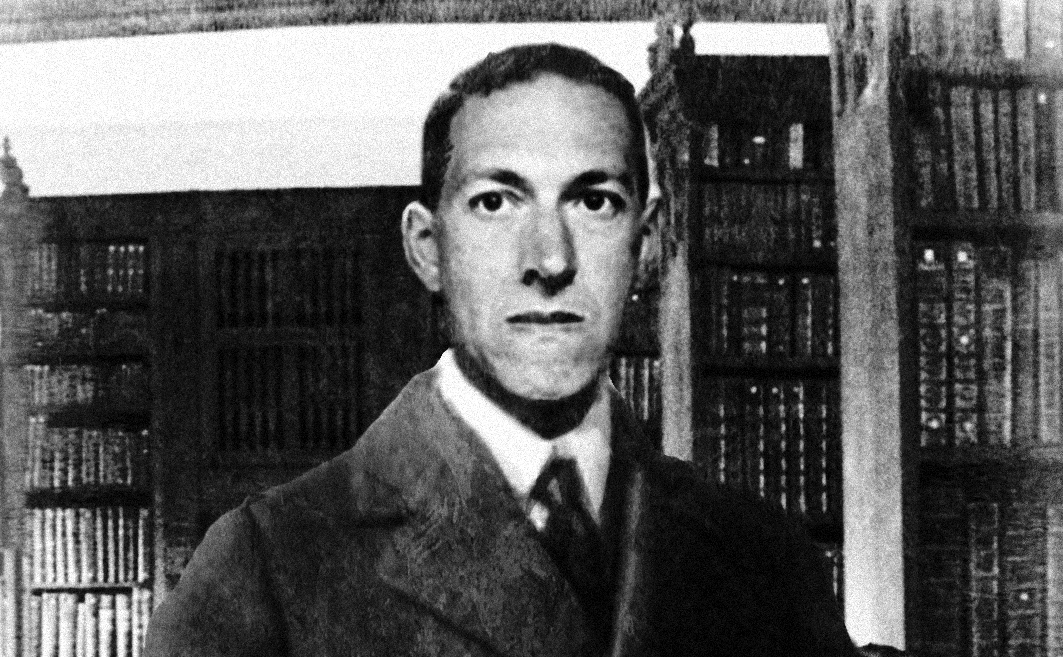

Howard Phillips Lovecraft naît en 1890 à Providence, Rhode Island, et meurt dans la même ville en 1937. Toute sa vie tient dans ce cercle étroit de la Nouvelle-Angleterre, à l’exception de quelques années à New York. Enfant unique, il perd son père très tôt : Winfield Scott Lovecraft, représentant de commerce, est interné à l’asile en 1893, atteint de syphilis tertiaire. Sa mère, Sarah Susan Phillips, descendante d’une vieille famille de Providence, reste auprès de lui jusqu’à sa propre internement à Butler Hospital en 1919. L’enfance de Lovecraft est donc marquée par la maladie, l’instabilité mentale, l’isolement. Il grandit surtout auprès de son grand-père maternel, Whipple Van Buren Phillips, dont la bibliothèque nourrira ses premières lectures : contes arabes, récits gothiques, The Arabian Nights, Pope, Gray. Très tôt, il découvre Poe, dont il lit et imite les récits avant même l’adolescence. Plus tard, à l’université (qu’il n’achèvera jamais), il s’initie aux sciences — astronomie, chimie — qui laisseront une empreinte durable. Son univers se construit sur cette double matrice : le fantastique sombre de Poe et la rationalité scientifique. La mort de son grand-père en 1904 le laisse sans soutien matériel : la famille sombre dans la pauvreté, il quitte l’école, n’entre jamais vraiment à Brown University. Sa vie adulte sera une suite de difficultés financières, d’emplois précaires, de publications alimentaires dans les pulps. Lovecraft n’aura pas de succès de son vivant. Il publie surtout dans Weird Tales, fondé en 1923, et dans d’autres magazines bon marché. Ses textes sont lus par un public restreint, parfois jugés obscurs ou maladroits. Mais il construit autour de lui un cercle de correspondants — Robert E. Howard, Clark Ashton Smith, August Derleth, Donald Wandrei — avec qui il échange des dizaines de milliers de lettres (plus de 100 000 selon Joshi). Cette correspondance forme une œuvre parallèle, gigantesque, où il expose ses lectures, ses théories esthétiques, ses idées politiques (souvent réactionnaires, voire racistes). Un autre moment biographique pèse : son mariage avec Sonia Greene en 1924 et son séjour new-yorkais. Installé à Brooklyn, Lovecraft vit l’expérience comme un exil. Pauvre, isolé, choqué par la diversité ethnique de la ville, il s’enfonce dans un sentiment d’hostilité cosmique. C’est là qu’il écrit certains de ses récits les plus sombres (The Horror at Red Hook). Le mariage échoue, il revient seul à Providence en 1926. Ces années de solitude marquent son imaginaire : cités cyclopéennes, entités monstrueuses, narrateurs solitaires confrontés à l’indifférence du cosmos. Malade (cancer de l’intestin diagnostiqué trop tard), affaibli par la pauvreté, il meurt en 1937 à 46 ans. Enterré à Providence, il laisse une œuvre encore dispersée, sauvée de l’oubli par Derleth et Wandrei qui fondent Arkham House en 1939. C’est grâce à eux que Lovecraft sort de l’ombre, puis grâce aux critiques comme S. T. Joshi qu’il est reconnu comme figure centrale du fantastique moderne.

Lovecraft n’émerge pas dans le vide : il se pense lui-même comme héritier. Dans son essai Supernatural Horror in Literature (1927), il établit une généalogie du genre, de l’antiquité au gothique, puis de Poe jusqu’aux contemporains. Poe est au sommet. Lovecraft écrit que Poe « éleva l’horreur surnaturelle à un plan artistique où nul autre Américain n’avait su la porter ». L’influence est double : le choix du récit bref, tendu vers un effet unique, et l’exploration des obsessions intérieures. The Tell-Tale Heart ou The Black Cat sont pour lui des modèles de condensation et d’intensité. Dans ses propres textes, il reprend la figure du narrateur délirant, mais lui adjoint une perspective cosmique : la peur n’est plus seulement psychologique, elle est métaphysique. Dunsany est l’autre grand modèle. Lovecraft découvre A Dreamer’s Tales et The Book of Wonder vers 1919. Dans une lettre, il avoue les avoir « lus et relus jusqu’à les connaître presque par cœur ». De Dunsany, il retient le ton biblique, les cités imaginaires, les panthéons inventés. Le « Dream Cycle » de Lovecraft — Polaris (1918), The White Ship (1919), Celephaïs (1920), The Dream-Quest of Unknown Kadath (1926–27) — est directement tributaire de ce modèle. La cadence lente, les noms étranges, l’impression d’un ailleurs fabuleux : tout vient de Dunsany. Mais là où Dunsany restait dans la grâce onirique, Lovecraft introduit une inquiétude : ces cités ne sont pas seulement des rêves, elles masquent une indifférence cosmique. Ces deux filiations — Poe et Dunsany — structurent son imaginaire. Mais Lovecraft les déplace. Chez Poe, l’horreur est intérieure ; chez Dunsany, elle est mythologique et rêveuse. Chez Lovecraft, elle devient cosmique. Ses dieux ne sont pas des symboles ni des figures morales : ce sont des entités extra-humaines, aveugles, indifférentes. Il refuse le surnaturel au sens traditionnel. Rien de miraculeux, rien d’angélique : seulement une nature élargie, immense, où l’homme n’est rien. Ses monstres — Cthulhu, Yog-Sothoth, Nyarlathotep — ne sont pas au-delà de la nature, ils sont la nature elle-même, vue dans son immensité. Cette inflexion matérialiste vient de ses lectures scientifiques. Adolescent, il publie des articles d’astronomie dans la presse locale, observe les étoiles, construit des cartes. Plus tard, il s’intéresse à la géologie, à l’anthropologie, aux théories contemporaines de la relativité et de la quatrième dimension. Dans ses récits, ces disciplines deviennent des sources d’effroi. At the Mountains of Madness (1931) décrit une expédition antarctique où la géologie révèle des cités préhumaines. The Colour out of Space (1927) met en scène une météorite qui contamine la terre par une radiation incompréhensible. La science n’abolit pas le mystère, elle l’amplifie. Ainsi Lovecraft hérite mais transforme. Poe lui donne l’intensité psychologique, Dunsany la majesté onirique. Lui les détourne vers un cauchemar où la science révèle l’indifférence cosmique. Le surnaturel se dissout dans le naturel élargi. L’horreur n’est pas que subjective, ni seulement mythologique : elle est cosmologique.

Le cauchemar cosmique prend forme dans quelques récits majeurs. Le plus célèbre est The Call of Cthulhu (écrit en 1926, publié en 1928 dans Weird Tales). Le narrateur, Francis Wayland Thurston, reconstitue un dossier fragmentaire : notes d’un professeur, témoignage d’un artiste, rapport d’un officier norvégien. Peu à peu se dessine l’existence d’un culte mondial, voué à une entité endormie sous les mers, Cthulhu. Ce dieu n’est pas une figure morale : il dort, rêve, attend. Sa simple résurgence menace l’humanité. La structure du récit est emblématique : enquête documentaire, indices dispersés, révélation finale insoutenable. S. T. Joshi souligne combien ce texte condense l’art lovecraftien : horreur par accumulation de fragments, effroi né de l’érudition. At the Mountains of Madness (1931, publié en 1936) élargit la perspective. Une expédition antarctique découvre les ruines cyclopéennes d’une cité bâtie par les Anciens, une race extraterrestre venue sur Terre des millions d’années avant l’homme. Par fragments de fresques et d’indices géologiques, le narrateur reconstitue l’histoire d’une planète colonisée, abandonnée, dévastée. Ici, l’horreur n’est pas un spectre mais une paléontologie. La science mène à la révélation que l’homme est un accident, tardif, insignifiant. Michel Houellebecq, dans son essai H. P. Lovecraft : Contre le monde, contre la vie, y voit le cœur de sa métaphysique : l’univers comme force étrangère, indifférente, où l’homme est de trop. The Shadow out of Time (1934–35) poursuit ce travail. Le professeur Nathaniel Wingate Peaslee, frappé d’amnésie, découvre que son esprit a été échangé avec celui d’une entité de la Great Race of Yith, race extraterrestre vivant dans le passé et le futur grâce à des transferts de conscience. Son cauchemar est double : avoir vécu dans un corps étranger, et savoir que sa propre conscience fut habitée par un être inhumain. Le texte articule mémoire, temporalité et vertige cosmique. L’horreur n’est plus spatiale mais temporelle : l’homme n’est qu’une étape dans une lignée infinie d’espèces. À ces trois récits s’ajoutent The Colour out of Space (1927), où une météorite contamine une ferme par une radiation incompréhensible, et The Dunwich Horror (1928), qui transpose l’horreur dans une Nouvelle-Angleterre rurale, saturée de folklore dégénéré. Dans tous les cas, la même logique : enquête, indices accumulés, révélation d’une présence cosmique. L’horreur n’est pas l’apparition immédiate mais la compréhension progressive. Ces textes forment le noyau de ce qu’August Derleth appellera plus tard « le Mythe de Cthulhu ». Mais Lovecraft lui-même n’avait pas cherché à créer un système clos. Ses dieux et entités apparaissent de manière diffuse, comme des fragments d’un cauchemar partagé. Cthulhu, Yog-Sothoth, Azathoth, Nyarlathotep : noms dispersés dans des récits, allusions, correspondances. Le mythe est moins une mythologie qu’une constellation. C’est justement ce caractère fragmentaire qui fascine. Le lecteur sent une cohérence possible, mais elle n’est jamais donnée. L’horreur réside dans cette impossibilité de totaliser.

La langue de Lovecraft est immédiatement reconnaissable, parfois caricaturée, souvent critiquée, mais essentielle à son effet. Elle combine archaïsmes, adjectifs accumulés, répétitions. Eldritch, unutterable, blasphemous, cyclopean : des mots qui semblent désuets mais qui créent une atmosphère de distance, comme si le texte n’était pas contemporain. S. T. Joshi insiste sur ce point : ce n’est pas maladresse mais stratégie. L’archaïsme donne à l’horreur une patine antique, un sentiment d’antériorité. La répétition de termes vagues — « indicible », « innommable » — produit moins une description qu’un effet d’impuissance, un langage qui avoue ses limites. La structure de ses récits est récurrente. Un narrateur, souvent scientifique ou érudit, entreprend une enquête. Il accumule des indices : manuscrits anciens, traditions orales, objets archéologiques, notes dispersées. Peu à peu, les fragments convergent vers une révélation. Mais cette révélation excède la raison et conduit à l’effondrement de la conscience. C’est le schéma de The Call of Cthulhu, de The Dunwich Horror, de At the Mountains of Madness. Donald R. Burleson, dans Lovecraft : Disturbing the Universe (1990), note combien cette structure reflète l’obsession de Lovecraft pour le savoir : l’horreur ne vient pas de l’ignorance mais de la compréhension. Le recours au vocabulaire scientifique est une autre particularité. Géologie, astronomie, biologie, archéologie : Lovecraft parsemait ses récits de détails empruntés à ses lectures. Dans At the Mountains of Madness, il décrit les strates géologiques de l’Antarctique avec une précision qui ancre le récit dans une vraisemblance scientifique. Dans The Colour out of Space, il imagine une forme de radiation extraterrestre qui décompose la matière vivante. La science n’est pas rassurante, elle est le vecteur même de l’effroi. Enfin, le choix des narrateurs est décisif. Ce sont presque toujours des hommes cultivés : professeurs, antiquaires, médecins. Leur rationalité devient instrument de leur perte. Là où le gothique classique opposait la superstition au savoir, Lovecraft inverse : c’est le savoir qui mène à la terreur. Plus on comprend, moins on peut supporter. Le narrateur est ainsi une figure tragique : il cherche la vérité, mais la vérité le détruit. L’effet lovecraftien tient donc à cette alliance : une langue archaïque qui produit le sentiment de l’ancien et de l’indicible ; une structure d’enquête qui mime la rationalité scientifique ; une chute où cette rationalité se retourne en folie. L’horreur ne surgit pas d’un spectre ou d’une apparition, mais du processus même de connaissance.

Au cœur de l’œuvre de Lovecraft, il y a ce que ses commentateurs appellent le cosmicisme. S. T. Joshi, dans The Weird Tale (1990) puis I Am Providence (2010), en fait le principe structurant de sa pensée : l’univers est indifférent, l’homme n’y occupe aucune place centrale, aucune providence ne le protège. Là où Poe enfermait la peur dans la conscience et où Dunsany créait des mythes de rêve, Lovecraft radicalise : tout mythe n’est qu’une fiction humaine face à un cosmos qui ne se soucie pas de nous. Ses dieux ne sont pas moraux. Cthulhu, Yog-Sothoth, Nyarlathotep, Azathoth ne jugent pas, ne punissent pas, ne sauvent pas. Ils existent en dehors de toute catégorie humaine. Azathoth, « le démon-sultan », incarne le chaos aveugle au centre de l’univers, un bouillonnement sans raison. Cthulhu dort sous les mers, indifférent. Yog-Sothoth est défini comme la totalité de l’espace-temps. Ces entités ne sont pas surnaturelles au sens religieux : elles sont naturelles, mais dans une nature élargie à l’échelle cosmique. Leur étrangeté vient de ce que nous ne pouvons pas les penser. Cette vision a des racines. Lovecraft lit les matérialistes antiques (Lucrèce, De rerum natura), mais aussi les sciences modernes : Darwin, l’astronomie, la physique contemporaine. Dans ses lettres, il insiste : « Toute ma philosophie est fondée sur l’idée que l’homme est un accident insignifiant dans un cosmos sans dessein. » Dirk W. Mosig, critique des années 1970, a souligné ce lien avec le matérialisme scientifique : le « Mythe de Cthulhu » n’est pas un système religieux, c’est une métaphore de l’indifférence universelle. Le savoir, chez Lovecraft, n’apporte pas le salut. Il mène à la folie. Plus on connaît, plus on mesure notre insignifiance. At the Mountains of Madness ne raconte pas une expédition ratée mais une révélation : les Anciens ont créé la vie, l’homme n’est qu’un déchet évolutif. The Shadow out of Time étend cette idée : notre conscience elle-même est contingente, susceptible d’être remplacée. Le cauchemar n’est pas l’absence de sens, mais le trop-plein de sens, un sens insoutenable. Houellebecq, dans H. P. Lovecraft : Contre le monde, contre la vie (1991), l’exprime à sa manière : « Dans l’univers de Lovecraft, il n’y a pas d’amour, pas d’espoir, pas de beauté durable. Seule reste l’horreur d’exister dans un monde qui ne nous veut pas. » Houellebecq, malgré ses excès, touche juste : Lovecraft est l’écrivain de la négation, du refus de toute transcendance consolante. Le cosmicisme n’est pas une doctrine systématique. C’est une attitude, un climat. Mais il marque un tournant : le fantastique cesse d’être une lutte entre le rationnel et le surnaturel, il devient confrontation avec l’indifférence cosmique. Poe avait réduit l’horreur à l’intérieur de la conscience, Dunsany avait élargi l’imaginaire au rêve mythologique, Lovecraft l’ouvre à l’univers tout entier. Son cauchemar est métaphysique : l’homme n’a pas de place.

De son vivant, Lovecraft reste confiné aux marges. Ses récits paraissent dans Weird Tales à partir de 1923, aux côtés de Robert E. Howard ou Seabury Quinn, pour un lectorat limité de passionnés. Les critiques littéraires l’ignorent, les maisons d’édition sérieuses ne le publient pas. Il vit pauvre, vend ses textes à vil prix, réécrit pour d’autres (revisions) afin de subsister. À sa mort en 1937, à Providence, il est inconnu du grand public, enterré sans éclat. C’est son cercle d’amis et de disciples qui assure sa survie. August Derleth et Donald Wandrei fondent en 1939 Arkham House, maison d’édition destinée à publier ses œuvres en volume. Ils imposent l’idée d’un « Mythe de Cthulhu », système plus cohérent que ce que Lovecraft avait laissé, en donnant à ses fragments la forme d’une mythologie. Grâce à eux, Lovecraft sort du ghetto des pulps et accède à une reconnaissance progressive. Dans les années 1960–70, la contre-culture redécouvre son pessimisme cosmique. Colin Wilson, puis Dirk W. Mosig, Donald R. Burleson, et surtout S. T. Joshi réévaluent son œuvre. Joshi, avec H. P. Lovecraft : A Life (1996) puis I Am Providence (2010), établit la biographie critique de référence, montrant que Lovecraft est un penseur cohérent, matérialiste, plus qu’un simple conteur de monstres. C’est par cette voie qu’il entre dans les études universitaires. L’influence littéraire est immense. Robert Bloch, Fritz Leiber, Ramsey Campbell prolongent son imaginaire. Stephen King, dans Danse macabre (1981), le cite comme l’une de ses sources majeures. Borges lui consacre une nouvelle, There Are More Things (1975). Michel Houellebecq, en 1991, en fait une figure emblématique du refus de l’humanisme moderne. Son empreinte s’étend au cinéma : The Thing de John Carpenter, Alien de Ridley Scott, ou encore The Mist de Frank Darabont reprennent ses thèmes — l’indicible, la créature informe, l’univers indifférent. Dans le jeu de rôle, Call of Cthulhu (Chaosium, 1981) transforme son univers en expérience collective, où les joueurs incarnent des enquêteurs condamnés à la folie. Dans la bande dessinée, Alan Moore (Providence, 2015–17) ou Mike Mignola (Hellboy) réinterprètent son mythe. Même la musique et les jeux vidéo (de Metallica à Bloodborne) portent sa trace. Le « Mythe de Cthulhu » est devenu une mythologie collective, prolongée bien au-delà de ce qu’il avait imaginé. Paradoxalement, lui qui n’avait pas voulu créer un système clos est devenu le centre d’un univers partagé, continuellement enrichi par d’autres. Ce qui témoigne de la force de son invention : une cosmologie fictive assez puissante pour dépasser son auteur. Aujourd’hui, Lovecraft occupe une place paradoxale : encore contesté pour son racisme et ses positions politiques, mais reconnu comme l’un des grands inventeurs de l’imaginaire moderne. Son cauchemar cosmique continue d’irriguer littérature, arts visuels et culture populaire. Comme l’écrit Joshi, « Lovecraft a donné à l’horreur une métaphysique », et c’est cette métaphysique de l’indifférence qui fait de lui un auteur central, au-delà même du fantastique.

Vous avez aimé cet article ? Soutenez Le Dibbouk en m'offrant un café.

Did you enjoy this article? Support the project by buying me a coffee.

Pour continuer

histoire de l’imaginaire

Enquête sur l’existence des vies antérieures

Depuis que l’être humain a conscience de sa propre finitude, une question hante les civilisations : la mort est-elle un point final ou une simple ponctuation ? Si l’Orient a intégré depuis des millénaires le concept du Samsara (le cycle des renaissances), l’Occident, nourri de rationalisme et de dualisme chrétien, a longtemps relégué l’idée des vies antérieures au rang de folklore ou de superstition New Age. Pourtant, depuis le milieu du XXe siècle, une brèche s’est ouverte. Ce n’est pas par la mystique qu’elle est arrivée, mais par une démarche clinique rigoureuse, tentant d’appliquer la méthode scientifique à l’inexplicable. Sommes-nous les héritiers de mémoires qui ne nous appartiennent pas ? Pour l’écrivain, cette hypothèse est fascinante car elle suggère que chaque individu est un palimpseste, un manuscrit où les textes anciens transparaissent sous l’écriture nouvelle. L’École de Virginie : Quand la science interroge le passé Le tournant décisif de cette enquête se situe à l’Université de Virginie, sous l’impulsion du Dr Ian Stevenson. Psychiatre de formation, Stevenson a consacré plus de quarante ans de sa vie à répertorier et analyser ce qu’il appelait pudiquement des « cas suggérant la réincarnation ». Loin des séances d’hypnose régressive — qu’il jugeait peu fiables car sujettes à l'imagination du patient — Stevenson s’est concentré sur les récits spontanés d’enfants en bas âge. Ces enfants, généralement âgés de 2 à 5 ans, commencent à décrire avec une précision troublante une vie précédente : des noms de lieux isolés, des noms de parents, des métiers, et surtout, les circonstances de leur mort, souvent violente. Stevenson a documenté plus de 2 500 cas à travers le monde (Inde, Liban, Turquie, mais aussi États-Unis). Ce qui rend ses travaux incontournables pour tout chercheur sérieux, c’est la vérification empirique. Dans des centaines de cas, Stevenson a pu retrouver la famille de la « personnalité antérieure » décrite par l’enfant. Il a confronté les affirmations de l’enfant avec les registres d’état civil, les rapports de police ou les dossiers médicaux de la personne décédée. La correspondance des détails (plus de 90 % de précision dans certains cas) défie les lois de la statistique et du simple hasard. Plus troublant encore est le phénomène des marques de naissance. Stevenson a noté que de nombreux enfants présentant des souvenirs de mort violente possédaient des taches de naissance ou des malformations congénitales correspondant exactement à l'emplacement des blessures mortelles reçues par le défunt (impacts de balles, traces d'armes blanches). Pour le Dr Jim Tucker, qui a repris le flambeau à l'Université de Virginie au XXIe siècle, ces données suggèrent que la conscience — ou une forme d'information complexe — pourrait agir sur la matière biologique lors de la formation de l'embryon. La Conscience Non-Locale : L'information peut-elle survivre au support ? Si les faits rapportés par l'école de Virginie troublent, ils se heurtent à un mur conceptuel : comment une mémoire pourrait-elle se transférer d'un cerveau mort à un cerveau en formation sans aucun support physique apparent ? Pour répondre, certains chercheurs se tournent vers une révolution de notre compréhension de la matière : la physique de l'information. L'hypothèse émergente est celle de la « conscience non-locale ». Dans ce modèle, le cerveau ne produirait pas la conscience comme le foie produit la bile, mais agirait plutôt comme un récepteur. Si l'on casse un poste de radio, la musique s'arrête, mais l'onde radio, elle, continue d'exister dans l'espace. Cette métaphore, bien que simpliste, illustre la théorie développée par le physicien Roger Penrose et l'anesthésiste Stuart Hameroff (théorie Orch-OR). Selon eux, la conscience prendrait racine dans les « microtubules », de minuscules structures à l'intérieur de nos neurones capables de maintenir des états quantiques. À la mort, cette information quantique ne serait pas détruite, mais se dissiperait dans l'univers sous une forme délocalisée. Si l'on suit cette logique, ce que nous appelons « réincarnation » pourrait être le processus par lequel cette information est à nouveau captée par un nouveau système biologique compatible. L’Énigme de la Mémoire Épigénétique Une autre piste, plus biologique celle-ci, explore l'épigénétique. Des études menées sur des souris ont montré que des traumatismes ou des apprentissages peuvent laisser des marques chimiques sur l'ADN, lesquelles sont transmises aux générations suivantes. Des descendants qui n'ont jamais été exposés au danger réagissent pourtant avec la même peur que leurs ancêtres. Pour l'écrivain, cette "mémoire de sang" est un ressort narratif puissant, mais pour la science, elle suggère que nous naissons avec un disque dur qui n'est pas vierge. Cependant, l'épigénétique explique la transmission au sein d'une même lignée familiale, là où les cas de Stevenson concernent souvent des familles totalement étrangères l'une à l'autre. C'est ici que le mystère reste entier : si ce n'est pas par les gènes, par quel canal l'information voyage-t-elle ? L'idée d'un « champ d'information » entourant la Terre — ce que le biologiste Rupert Sheldrake appelle les champs morphiques — propose que la nature possède une mémoire, et que chaque individu puise dans cette mémoire collective tout en l'enrichissant. Cette vision rejoint les "Annales Akashiques" des traditions anciennes, mais reformulée dans le langage de la résonance et des fréquences. Le Miroir des Sceptiques : Les pièges de la mémoire Face à ces récits troublants, la science rationaliste ne reste pas muette. Elle propose des explications qui, bien que moins "romantiques", s'appuient sur les failles connues du cerveau humain. Le concept clé ici est celui de la cryptomnésie, ou mémoire cachée. Le cerveau est une éponge extraordinaire. Nous absorbons quotidiennement des milliers d'informations — un nom sur une tombe aperçue furtivement, un détail dans un film documentaire oublié, une conversation entendue dans l'enfance. Des années plus tard, sous hypnose ou lors d'un état de conscience modifié, ces fragments peuvent ressurgir. Le sujet croit alors accéder à un souvenir d'une vie passée, alors qu'il ne fait que recomposer, tel un romancier inconscient, une histoire à partir de débris de sa propre vie actuelle. La Fabrique des Faux Souvenirs Les travaux de la psychologue Elizabeth Loftus sur la malléabilité de la mémoire sont ici fondamentaux. Elle a démontré qu'il est possible d'implanter de faux souvenirs dans l'esprit d'un individu par la simple suggestion. Dans le cadre de la "thérapie par régression", si le thérapeute pose des questions orientées (ex : "Que voyez-vous de votre vie en Égypte ?"), le patient, par désir inconscient de plaire ou par besoin de donner un sens à ses blocages, peut construire de toutes pièces un scénario cohérent. Ce phénomène est accentué par la confabulation : le cerveau déteste le vide. Face à une sensation inexpliquée ou une angoisse, il crée une narration pour justifier l'émotion. Si vous avez une peur irrationnelle de l'eau, votre esprit pourrait "inventer" une noyade sur le Titanic pour donner une forme logique à cette peur. Le Biais Culturel : On ne se réincarne pas au hasard Un autre argument de poids des sceptiques est l'influence de la culture. On remarque que les récits de vies antérieures suivent souvent les croyances locales. En Inde, les enfants se souviennent souvent de castes différentes. En Occident, les souvenirs sont plus souvent liés à des périodes historiques médiatisées. Cette corrélation suggère que l'imaginaire collectif nourrit les récits individuels. Toutefois, les sceptiques eux-mêmes peinent à expliquer les cas de Stevenson où l'enfant fournit des détails techniques (comme l'utilisation d'outils spécifiques à un métier disparu) qu'il n'aurait jamais pu rencontrer, même par hasard, dans son environnement. C'est là que le débat reste ouvert : si 90% des cas peuvent être expliqués par la psychologie, qu'en est-il des 10% restants qui résistent à toute analyse rationnelle ? Conclusion : La vie comme un palimpseste Que l’on aborde l’hypothèse des vies antérieures sous l'angle de la survie de l’information quantique ou sous celui d’une construction psychologique sophistiquée, une chose demeure : cette idée agit comme un puissant révélateur de notre rapport au temps. Si nous acceptons, ne serait-ce que comme expérience de pensée, que nous sommes le résultat d’une accumulation d’existences, notre perception de l’identité s’en trouve radicalement transformée. Nous ne sommes plus des êtres isolés dans une parenthèse de quelques décennies, mais des nœuds au sein d’une immense toile mémorielle. L'impact sociétal : Vers une écologie de l'esprit ? L'acceptation d'une forme de persistance de la conscience pourrait avoir des conséquences éthiques majeures. Dans une société marquée par l'immédiateté et la consommation, l'idée de "conséquence à long terme" (le fameux Karma des anciens) redonne une responsabilité à l'individu. Si je suis le futur héritier de mes actes présents, mon rapport à l'autre et à la planète change de nature. Ce n'est plus seulement par altruisme que l'on protège le monde, mais par une forme de continuité de soi. Pour la psychologie moderne, l’exploration de ces récits — qu’ils soient littéralement vrais ou symboliquement construits — offre une voie de guérison unique. Elle permet de mettre des mots sur des maux indicibles, de donner un cadre narratif à des traumas qui, autrement, resteraient des ombres sans nom. En tant qu'écrivain, nous savons que le "récit" est l'outil le plus puissant pour structurer le chaos de l'âme humaine. Le mot de la fin : Un mystère nécessaire En définitive, le débat entre les tenants de la preuve clinique (Stevenson, Tucker) et les défenseurs de la rationalité (Loftus, Sagan) n'est peut-être pas prêt de se clore. Et c'est peut-être là une chance. Le mystère des vies antérieures nous oblige à rester humbles face à la complexité du réel. Il nous rappelle que la science, si elle explique brillamment le "comment", peine encore à saisir le "pourquoi". Que nous soyons des voyageurs de l'espace-temps ou simplement des architectes de notre propre imaginaire, l'hypothèse des vies antérieures nous invite à regarder chaque être humain avec une curiosité renouvelée : et si cette personne en face de moi contenait, en elle, mille autres histoires que je ne connais pas encore ? Bibliographie sélective : Pour aller plus loin 1. L'approche clinique (Les références mondiales) Dr Ian Stevenson – Vingt cas suggérant le phénomène de réincarnation (Éditions J'ai Lu / Sand) : C'est la bible du sujet. Stevenson y détaille ses enquêtes les plus célèbres avec une neutralité de ton presque chirurgicale. Incontournable pour comprendre sa méthode de vérification. Dr Jim B. Tucker – Retour à la vie : Enquêtes sur des enfants qui se souviennent de leurs vies antérieures (Éditions Dervy) : Le successeur de Stevenson à l'Université de Virginie apporte une touche plus moderne et analyse des cas récents, notamment aux États-Unis, avec une approche très scientifique sur la persistance de la conscience. 2. L'approche psychologique et thérapeutique Dr Brian Weiss – Une seule âme, de nombreux corps (Éditions J'ai Lu) : Psychiatre diplômé de Yale, Weiss raconte comment il a basculé dans cette croyance suite à une séance d'hypnose avec une patiente. Bien que plus narratif, cet ouvrage est un classique sur l'utilisation thérapeutique de ces souvenirs. Dr Helen Wambach – Revivre ses vies antérieures (Éditions Robert Laffont) : Une étude fascinante car elle est statistique. Elle a interrogé sous hypnose plus de 1000 sujets et a comparé leurs descriptions (vêtements, monnaie, outils) avec les données historiques réelles de l'époque citée. 3. L'approche théorique et physique Rupert Sheldrake – La Mémoire de l'Univers (Éditions du Rocher) : Le biologiste y expose sa théorie des "champs morphiques". Ce n'est pas un livre sur la réincarnation en soi, mais il explique comment une mémoire de la nature pourrait permettre la transmission d'informations d'un individu à un autre. Stéphane Allix – Après... (Éditions Albin Michel) : Le fondateur de l'INREES (Institut de Recherche sur les Expériences Extraordinaires) propose une enquête très documentée sur la vie après la mort, incluant les recherches sur la réincarnation, avec un regard de journaliste d'investigation. 4. Le regard critique (Scepticisme scientifique Elizabeth Loftus – The Myth of Repressed Memory (En anglais, ou ses articles traduits) : Bien qu'elle ne traite pas directement de réincarnation, ses travaux sur les faux souvenirs sont la base de la critique rationnelle du sujet. Indispensable pour comprendre comment le cerveau peut "inventer" un passé.|couper{180}

histoire de l’imaginaire

Le paradoxe de la table

J'ai remarqué la chose pour la première fois dans un Monoprix du quinzième arrondissement, un jeudi après-midi de novembre. Une femme remplissait son caddie de produits light. Yaourts zéro pour cent. Sodas sans sucre. Barres de céréales enrichies en fibres. Elle portait des baskets de running à trois cents euros et une montre connectée qui devait surveiller ses pas, son sommeil, son rythme cardiaque. À la caisse d'à côté, un homme achetait des paquets de biscuits industriels, des plats préparés, deux litres de Coca-Cola. Il était plus jeune qu'elle, peut-être trente ans. Il était aussi beaucoup plus gros. Ce n'était pas la première fois que je voyais cette scène. Ce ne serait pas la dernière. Mais ce jour-là, quelque chose s'est cristallisé. Une évidence que personne ne dit : nous ne mangeons plus les mêmes choses parce que nous n'habitons plus le même monde. On parle beaucoup de la malbouffe. On en parle comme d'un fléau démocratique, comme si nous étions tous également exposés à la tentation du sucre et du gras. Comme si c'était une question de volonté individuelle, d'éducation, de choix. Mais les chiffres disent autre chose. Les chiffres disent que l'obésité a une adresse, un code postal, un revenu. Les chiffres disent que plus vous êtes pauvre, plus vous avez de chances d'être gros. Et plus vous êtes riche, plus vous avez de chances d'être mince. Ce n'est pas nouveau. Brillat-Savarin le savait déjà au dix-neuvième siècle : dis-moi ce que tu manges, je te dirai qui tu es. Ce qui est nouveau, c'est l'inversion. Pendant des siècles, être gros signifiait être riche. Cela signifiait avoir accès à l'abondance, aux festins, à la viande rouge et au bon vin. Les paysans étaient maigres. Les bourgeois étaient ventripotents. C'était l'ordre des choses. Aujourd'hui, l'ordre s'est inversé. Les riches sont minces. Ils font du yoga. Ils mangent du quinoa et du saumon sauvage. Ils achètent bio. Ils ont le temps de courir le matin avant d'aller travailler. Les pauvres sont gros. Ils mangent ce qu'ils peuvent. Ils mangent ce qui ne coûte pas cher. Ils mangent ce qui les remplit vite. Ils n'ont pas le temps. C'est un paradoxe. Un paradoxe étrange et cruel. Nous vivons dans une société d'abondance alimentaire inédite dans l'histoire de l'humanité, et pourtant nous reproduisons les mêmes inégalités corporelles que nos ancêtres. Simplement, nous les avons inversées. La maigreur est devenue le privilège. L'obésité est devenue la punition. Je pense à cette femme dans le Monoprix. Je pense à son caddie rempli de promesses : zéro calories, zéro sucre, zéro culpabilité. Je pense à l'homme à côté. Je pense à ce que leurs caddies disent d'eux, de nous, de ce que nous sommes devenus. Le tournant C'était dans les années soixante-dix, quatre-vingt. Le Dr. Robert Atkins publie son régime révolutionnaire : moins de glucides, plus de protéines. En 1987, Michel Montignac sort Je mange donc je maigris et introduit la notion d'index glycémique dans le grand public. Plus tard, Jean Seignalet proposera son régime hypotoxique, excluant le blé et les produits laitiers. Ces hommes — tous des hommes, d'ailleurs — ont transformé l'acte de manger en une science. Une science accessible aux masses, vulgarisée, simplifiée, mais une science quand même. La généalogie de l'ascèse Dans le judaïsme, l'alimentation n'a jamais été une affaire triviale. La cacherout — les lois alimentaires juives — ne dit pas seulement quoi manger, mais comment le manger. Séparer le lait de la viande. Refuser le porc. Saigner la viande selon un rituel précis. Ces interdits créent un espace de réflexion entre le désir et la satisfaction. « La loi intervient pour freiner ce besoin très simple et place la réflexion avant la consommation », explique le rabbin Pauline Bebe. Se nourrir n'est plus un acte banal. C'est un acte conscient. Un acte spirituel. La Kabbale, cette mystique juive, va encore plus loin. Pour les kabbalistes, chaque aliment contient des étincelles de divinité qu'il faut « relever » — libérer et ramener vers leur source céleste. Manger devient un acte de réparation du monde, une opération mystique où se joue une véritable « bataille » entre le corps et l'âme. À table, disent-ils, l'intention compte autant que la nourriture elle-même. Par la cacherout et la conscience, le mangeur place son corps sous le contrôle d'un projet spirituel plutôt que sous celui de l'appétit. Le corps n'est pas méprisé — il est le véhicule de l'âme. Et l'âme a besoin d'un véhicule propre, discipliné, maîtrisé. Dans l'islam, le soufisme — la voie mystique — enseigne la maîtrise du corps comme chemin vers Dieu. Les soufis ont développé ce qu'ils appellent l'« alchimie de l'âme », une discipline rigoureuse où le jeûne joue un rôle central. Leurs manuels, du dixième au quatorzième siècle, décrivent avec précision la progression : commencer par jeûner trois jours, puis étendre progressivement jusqu'à quarante jours ou plus. L'objectif est de dompter le nafs — l'ego charnel, la partie animale de l'être qui nous tire vers le bas. Certains maîtres soufis parlent de « mort blanche » pour décrire ce processus. Par la faim volontaire, le corps s'affaiblit, et c'est précisément cet affaiblissement qui permet au cœur de s'illuminer. Le corps doit être léger, presque transparent, pour que l'esprit puisse s'élever. « Qui connaît Dieu, l'aime ; qui connaît le monde y renonce. » Quarante jours de faim, disait l'un d'eux, peuvent transformer les ténèbres du cœur en lumière. Ce que les mystiques ont toujours su — ce que les kabbalistes et les soufis pratiquaient dans le secret de leurs confréries — c'est que la maîtrise du corps ouvre la porte à quelque chose de plus grand. La faim n'est pas une punition. C'est une technologie spirituelle. Un moyen de purifier non pas le corps, mais l'âme. Le grand déplacement Puis quelque chose a changé. Pas brutalement. Progressivement. Les pratiques sont restées, mais leur sens s'est déplacé. Aujourd'hui encore, des millions de personnes jeûnent pour des raisons religieuses. Le Ramadan. Le Carême orthodoxe. Le jeûne bahá'í. Ces pratiques millénaires continuent, imperturbables. Mais nous les regardons différemment. Nous les mesurons différemment. Des chercheurs allemands ont récemment étudié le jeûne sec pratiqué par les bahá'ís — adeptes d'une religion monothéiste fondée au dix-neuvième siècle en Perse, qui observent chaque année un jeûne de dix-neuf jours durant le mois de 'Alá, dernière période de leur calendrier avant le Naw-Rúz (nouvel an). Dix-neuf jours consécutifs sans manger ni boire du lever au coucher du soleil. Ils ont équipé les participants de capteurs de glucose en continu. Résultat : pas d'effet négatif sur la glycémie. Une étude grecque sur le jeûne orthodoxe a mesuré le cholestérol, les triglycérides, l'IMC. Conclusion : réduction significative du poids et du tour de taille. Une méta-analyse portant sur plusieurs jeûnes religieux - islam, orthodoxie, bahá'isme - a compilé les courbes glycémiques, les niveaux de cholestérol, les variations de poids. Ce glissement est fascinant. Ce qui était une ascèse spirituelle — un combat contre l'ego, une quête de lumière intérieure — devient un objet d'analyse métabolique. On ne demande plus si le jeûne rapproche de Dieu. On demande s'il fait baisser le cholestérol. Le jeûne intermittent en est l'aboutissement logique. Inspiré des pratiques religieuses mais vidé de leur contenu spirituel, il est devenu une technique de gestion du poids. On ne jeûne plus pour purifier son âme mais pour optimiser sa glycémie. On ne cherche plus la « mort blanche » mais la perte de graisse abdominale. Les applications comptent les heures. Les influenceurs partagent leurs protocoles. Le 16:8, le 5:2, le OMAD (one meal a day). Des acronymes pour ce qui était autrefois un mystère. L'index glycémique, inventé dans les années 1980, est devenu le nouveau principe organisateur. Il a remplacé les tables de la Loi. Il classe les aliments non selon leur pureté spirituelle mais selon leur impact sur le sucre sanguin. Les nutritionnistes créent des régimes « périodisés » — manger plus les jours de décision, moins les jours calmes — transposant aux dirigeants d'entreprise les protocoles des athlètes olympiques. La discipline demeure. La finalité a changé. Ce que les mystiques cherchaient — cette emprise totale sur l'appétit, cette capacité à transcender la faim — les régimes modernes l'ont sécularisé. Ils ont remplacé Dieu par l'index glycémique. Ils ont remplacé la purification de l'âme par la purification du corps. Mais le principe reste le même : la discipline alimentaire comme marqueur de distinction. La capacité à dire non comme signe d'élévation. La différence, c'est que les mystiques choisissaient leur ascèse. Les pauvres d'aujourd'hui ne choisissent pas leur obésité. Le contrôle par l'assiette Il y a quelque chose de profondément insidieux dans ce nouveau régime des corps. Ce n'est plus seulement une question de qui mange quoi. C'est une question de qui contrôle qui. Les riches ne se contentent pas de manger différemment. Ils ont fait de leur alimentation une discipline, presque une religion. Ils comptent leurs macronutriments. Ils suivent des protocoles. Ils font des jeûnes intermittents. Ils ont transformé le fait de manger — cette nécessité la plus basique, la plus animale — en un projet moral. Manger devient un acte de volonté. Ne pas manger devient un signe de maîtrise de soi. Un récit circule sur les réseaux sociaux. Un homme se présente comme ancien chef privé d'une grande famille de banquiers. Il énumère les aliments bannis de leurs cuisines : fritures, pâtisseries, jus de fruits, même la menthe. Chaque choix, dit-il, est validé par un neurologue pour optimiser la vigilance et la prise de décision. L'histoire est invérifiable. Peut-être est-elle vraie. Peut-être est-elle une fiction. Peu importe. Ce qui compte, c'est qu'elle circule. Ce qui compte, c'est qu'elle semble crédible. Mikaela Reuben, elle, est bien réelle. Cette chef canadienne a passé quinze ans à cuisiner pour Ryan Reynolds, Hugh Jackman, des athlètes olympiques. Elle parle d'une « cuisine fonctionnelle » : beaucoup de végétaux, peu de sucres rapides, très peu d'alcool. L'objectif n'est pas le plaisir — ou du moins, pas seulement. L'objectif est la performance. L'énergie stable. La clarté mentale. Woody Harrelson, dit-elle, est « laser-focused » sur les aspects nutritionnels de chaque repas. Ce n'est pas de la gourmandise. C'est de l'ingénierie. Les nutritionnistes transposent désormais ces protocoles d'athlètes aux dirigeants d'entreprise. Adapter son alimentation à son emploi du temps. Manger plus les jours de décisions importantes. Manger moins les jours calmes. Comme un sportif qui charge en glucides avant une compétition. Bourdieu l'avait déjà vu dans les années soixante-dix. Dans La Distinction, il montrait que les classes supérieures préfèrent la forme au fond, le contrôle à l'abandon, la légèreté à la substance. Les classes populaires, disait-il, mangent pour se remplir. Les classes supérieures mangent pour se sculpter. Ce qui a changé depuis Bourdieu, c'est l'intensité de cette discipline. Les applications qui comptent les calories. Les balances connectées. Les coachs nutritionnels. Les régimes cétogènes, paléo, sans gluten. Tout un arsenal technologique et idéologique qui demande du temps, de l'argent, de l'attention. Des ressources que tout le monde n'a pas. L'épreuve du restaurant J'ai déjeuné un jour dans un restaurant gastronomique. Deux étoiles, je crois. Ou trois. Je ne sais plus. On m'y avait invité. L'addition dépassait mon budget mensuel pour la nourriture. L'expérience était remarquable. Elle était aussi troublante. Troublante parce qu'elle révélait une vérité qu'on ne dit pas : cette connaissance du goût m'était offerte pour un soir, mais je n'aurais jamais les moyens de l'entretenir. Chaque assiette racontait une histoire — la provenance des produits, les techniques de cuisson, les accords subtils. Je hochais la tête. Je souriais. Et sous le plaisir, quelque chose me serrait la gorge. La violence symbolique n'était plus un concept. C'était une sensation physique. C'était mon corps qui comprenait qu'il n'était pas à sa place. Pas assez mince. Pas assez discipliné. Pas assez léger. Mon corps qui portait l'histoire de sa classe comme une condamnation. Ce qui me frappait le plus, c'était la légèreté des autres convives. Leur aisance. Leur façon de parler des plats comme si c'était naturel d'en parler ainsi. Leurs corps qui ne trahissaient aucune ambivalence, aucun vertige. Cette certitude tranquille d'être à leur place. La mémoire du corps Mon père ne savait pas comment donner son affection. Alors il donnait à manger. Trop. Beaucoup trop. Des plats lourds, riches, interminables. Je crois qu'il avait lui-même manqué de quelque chose, enfant. Je crois qu'il essayait de combler chez moi un vide qu'il portait en lui. La nourriture était son langage d'amour. Un langage défaillant, mais le seul qu'il possédait. J'ai grandi avec cette ambivalence : le dégoût de la nourriture et une attirance irrépressible. Oscillation permanente. Trop manger ou ne rien manger. Les deux pôles d'un même vertige. Plus tard, j'ai eu une compagne qui cuisinait admirablement. Elle était juive. Elle préparait des plats magnifiques, savoureux, généreux. Mais elle détestait se mettre à table. Elle me servait puis disparaissait. Ou bien elle restait là, debout, à me regarder manger avec une expression que je n'arrivais pas à déchiffrer. Circé, j'ai pensé. La magicienne qui transforme les compagnons d'Ulysse en porcs. Cette nourriture qui m'engourdissait, qui installait cette torpeur dont je ne savais pas si elle était plaisir ou piège. Qui contrôlait qui dans cette cuisine ? Était-ce un don ou une assignation ? Quand la nourriture devient langage d'amour — que ce soit chez mon père ou chez cette compagne — pourquoi faut-il toujours qu'elle charrie aussi du pouvoir ? Et pourquoi ceux qui reçoivent portent-ils cette culpabilité, alors que ce sont peut-être ceux qui donnent qui sont prisonniers de leur propre geste ? Les échos de l'histoire Cette histoire n'est pas nouvelle. Simplement, elle change de costume à chaque époque. Au dix-huitième siècle, avant la Révolution, les aristocrates mangeaient du pain blanc. Le peuple mangeait du pain noir. Le pain blanc était un signe de distinction. Il fallait de la farine fine, des techniques raffinées, du temps. Le pain noir était grossier, rustique, ordinaire. Quand les révolutionnaires ont voulu imaginer une société égalitaire, ils ont parlé de pain. Le pain de l'égalité. Un pain pour tous. Au dix-neuvième siècle, pendant la révolution industrielle, les ouvriers mangeaient des pommes de terre et du pain. Les bourgeois mangeaient de la viande. Zola a écrit des pages entières sur la faim dans Germinal. La faim qui tenaille, qui obsède, qui rend fou. Face à cette faim, les banquets bourgeois, obscènes d'abondance. Au vingtième siècle, après la Seconde Guerre mondiale, on a cru que l'abondance résoudrait tout. La société de consommation promettait l'accès pour tous à la viande, aux produits laitiers, aux fruits exotiques. Pendant quelques décennies, les inégalités alimentaires ont semblé se réduire. Tout le monde pouvait manger à sa faim. Mais l'abondance a créé un nouveau problème. Quand tout le monde peut manger de la viande, la viande n'est plus un signe de distinction. Il faut inventer autre chose. Et ce quelque chose, c'est la minceur. C'est le bio. C'est le local. C'est l'orthorexie. C'est cette capacité à dire non à l'abondance. À se restreindre volontairement dans un monde d'excès. La distinction s'est déplacée. Elle ne se lit plus dans ce qu'on mange, mais dans ce qu'on refuse de manger. La liberté et ses entraves On parle beaucoup de liberté de choix. Les discours publics sur l'obésité insistent sur la responsabilité individuelle. Mangez mieux. Bougez plus. Prenez soin de vous. Comme si c'était simple. Comme si c'était juste une question de volonté. Mais quelle liberté pour quelqu'un qui travaille douze heures par jour, rentre épuisé, n'a qu'un Lidl dans son quartier et pas de marché bio ? Quelle liberté pour quelqu'un qui ne sait pas cuisiner parce que personne ne lui a appris, parce que dans sa famille on a toujours mangé du tout-prêt ? Qui n'a pas le temps de faire du meal prep le dimanche. Qui n'a pas les moyens d'acheter du saumon bio à trente euros le kilo. Qui mange ce qui est rapide, accessible, bon marché. Et ce qui est bon marché, dans notre système alimentaire industriel, c'est précisément ce qui rend gros. Je pense à cette phrase que j'ai lue quelque part : « La liberté, ce n'est pas de pouvoir faire ce qu'on veut. C'est de pouvoir vouloir ce qu'on fait. » Les gens qui remplissent leurs caddies de produits transformés, est-ce qu'ils veulent vraiment ces produits ? Ou est-ce qu'ils n'ont pas d'autre option, pas d'autre imaginaire possible ? Le système alimentaire contemporain crée des corps différenciés. Des corps minces et disciplinés d'un côté. Des corps gros et indisciplinés de l'autre. Et ces corps portent la marque de leur classe sociale aussi sûrement qu'un blason au Moyen Âge. On ne prête qu'aux riches. Et les riches se paient le luxe suprême : la légèreté. Conclusion : L'imaginaire de la table comme champ de bataille L'alimentation n'a jamais été qu'une question de calories. Elle a toujours été un langage, un système de signes, un théâtre où se jouent les rapports de pouvoir. Ce qui rend notre époque particulière, c'est la sophistication de ce langage. Nous avons transformé l'acte de manger en une discipline quasi-mystique, empruntant aux traditions religieuses leur vocabulaire de pureté et de contrôle tout en l'habillant du costume de la science. L'index glycémique remplace le rituel, le coach nutritionnel remplace le confesseur, mais la structure demeure : certains corps sont marqués comme purs, d'autres comme impurs. Cette histoire s'inscrit dans un imaginaire plus vaste que nous explorons dans cette rubrique : celui des hiérarchies invisibles qui structurent nos sociétés. Comme le golem qui s'anime par les lettres gravées sur son front, nos corps sont modelés par les mots qu'on y inscrit — « sain », « équilibré », « discipliné » d'un côté ; « incontrôlé », « négligent », « indiscipliné » de l'autre. La vraie question n'est pas : que devrait-on manger ? Mais plutôt : qui décide de ce que signifie bien manger ? Et surtout : pourquoi certains ont-ils le privilège de choisir leur propre ascèse, tandis que d'autres subissent celle que leur impose leur condition ? Dans la forêt sombre de nos imaginaires contemporains, l'alimentation est devenue l'un des derniers territoires où se négocient les frontières entre classes. Après avoir épuisé les autres marqueurs — l'accent, le vêtement, le lieu de résidence —, nous avons fait du corps lui-même le blason ultime. Les blasons peuvent être défigurés. Les imaginaires peuvent être récrits. Mais comment commence-t-on à défaire ce qui s'est inscrit si profondément dans nos corps, dans nos gestes quotidiens, dans la façon dont nous offrons et refusons la nourriture ? Et si l'histoire qu'on se raconte sur la table était justement celle qu'on ne peut pas changer seul — celle qui se change seulement quand on cesse de manger dans des mondes séparés ? Encadré — Le triangle de la distinction alimentaire Trois pôles structurent l'imaginaire alimentaire contemporain : Pureté : bio, local, sans additifs, « clean eating » — le fantasme d'une alimentation non contaminée par l'industrie. Performance : macronutriments, nutrition périodisée, optimisation cognitive — le corps comme machine à optimiser. Ascèse : jeûne intermittent, restrictions volontaires, capacité à dire non — la maîtrise de soi comme capital symbolique. Ces trois dimensions se recoupent dans les pratiques des classes supérieures, créant un système de signes qui fonctionne comme langage de distinction. Encadré — L'inversion historique Période Signe de richesse Signe de pauvreté Avant XXe Corpulence, viande, pain blanc Maigreur, légumes, pain noir Après XXe Minceur, légumes, aliments « purs » Corpulence, viande transformée, produits industriels Ce renversement n'est pas un progrès moral mais un déplacement des frontières symboliques. Lexique réutilisable Distinction alimentaire : processus par lequel les choix alimentaires deviennent des marqueurs de classe sociale (Bourdieu). Nutrition périodisée : adaptation de l'alimentation en fonction des besoins variables (concept emprunté aux athlètes, transposé aux dirigeants). Orthorexie : obsession pathologique pour une alimentation « saine » ; forme extrême du contrôle alimentaire. Cuisine fonctionnelle : approche de l'alimentation centrée sur la performance cognitive et physique plutôt que sur le plaisir. Sécularisation de l'ascèse : transformation des pratiques religieuses de contrôle du corps (jeûne, restrictions) en pratiques laïques et scientifiques. Sources citées BOURDIEU, Pierre. La Distinction : Critique sociale du jugement, Les Éditions de Minuit, 1979. BRILLAT-SAVARIN, Jean Anthelme. Physiologie du goût, 1825. SPENDLOVE, Jessica. « Fuelling Excellence : Nutrition Secrets from Elite Athletes for Corporate Leaders », jessicaspendlove.com, 2024. REUBEN, Mikaela. Interview, The Globe and Mail, « For chef Mikaela Reuben, cooking for Hollywood stars and athletes comes with a side of adventure », juin 2025. « 10 Worst Foods for Brain Health », Eskag Sanjeevani Hospitals, 2025. « 7 Foods Neurologists Warn Damage Brain Health », BuzzFeed/HuffPost, décembre 2025. BEBE, Pauline (rabbin). « Dans le judaïsme, la nourriture est spirituelle », La Croix, juillet 2015. FEUILLEBOIS-PIERUNEK, Eve. « La maîtrise du corps d'après les manuels de soufisme (Xe-XIVe siècles) », Revue des mondes musulmans et de la Méditerranée, 2006. ATKINS, Robert. Dr. Atkins' Diet Revolution, 1972. MONTIGNAC, Michel. Je mange donc je maigris, Flammarion, 1987. SEIGNALET, Jean. L'Alimentation ou la troisième médecine, éditions François-Xavier de Guibert, 1996. Note d'usage Ce texte s'inscrit dans la lignée des essais sur l'imaginaire contemporain explorés dans cette rubrique. Comme pour l'écophagie ou la science-fiction indienne, il s'agit de montrer comment nos mythes modernes (ici, la « santé parfaite ») reproduisent et amplifient les structures de pouvoir existantes. Illustration "Supermarket Lady" de Duane Hanson (1969)|couper{180}

histoire de l’imaginaire

Qui tient le dictionnaire des noms ?

Dans les systèmes numériques, un « nom » n’est pas un simple label : c’est une poignée opératoire. Le Triangle de Zooko soutient qu’un système de noms ne peut pas être à la fois humain-mental (mémorisable), sécurisé et décentralisé — on n’obtient que deux propriétés sur trois. Les DIDs (Decentralized Identifiers — Identifiants décentralisés), normalisés par le W3C, prétendent recomposer ce triangle : des identifiants contrôlés par leurs détenteurs, résolvables sans autorité centrale, vérifiables cryptographiquement, et reliés à des preuves (verifiable credentials). Que résolvent-ils vraiment ? Et que laissent-ils ouvert ? (Wikipédie) Le triangle de Zooko Le Triangle de Zooko pose une contrainte simple et tenace : pour un système de nommage (noms d’utilisateurs, adresses, domaines, identités), on voudrait des noms mémorisables par des humains, sécurisés (difficiles à usurper) et décentralisés (sans racine d’autorité unique). La conjecture dit : choisissez-en deux. Le DNS (avec DNSSEC) est humain-mental et sécurisé, mais centralisé (racines ICANN). Les adresses bitcoin ou .onion sont sécurisées et décentralisées, mais illisibles pour l’humain. D’autres systèmes bricolent des répertoires locaux « de confiance » : humains et parfois sécurisés, mais qui ne passent pas l’échelle globale. (Wikipédie) Cette trilemme a suscité, depuis vingt ans, des tentatives de « carré » : tout avoir. Les années 2010 ont vu émerger des solutions à base de blockchain (Namecoin, ENS, Handshake…) promettant des noms lisibles, sécurisés et décentralisés. Les papiers techniques restent partagés sur le verdict : gains réels (résistance à la censure, auto-authentification), mais coûts en gouvernance, risques de captation de noms rares et attaques Sybil si les mécanismes d’attribution sont faibles. Le triangle n’est pas renversé, il est déplacé : une propriété « gagnée » se paie ailleurs (allocation, arbitrage, lisibilité universelle). (arXiv) C’est dans ce paysage que le W3C a standardisé les DIDs — Decentralized Identifiers (DID) v1.0 — Identifiants décentralisés — en Recommandation (19 juillet 2022). Un DID ressemble à ceci : did:method:clé, où method indique comment résoudre l’identifiant (dans une blockchain, un registre distribué, un service pair-à-pair…), et clé pointe vers un document DID (DID Document) qui contient des métadonnées : clés publiques, services de résolution, paramètres de rotation ou de révocation. L’idée : découpler l’identité d’une personne ou d’un service de tout registre central, tout en permettant la vérification cryptographique et la portabilité. (W3C) Les DIDs prennent sens avec les Verifiable Credentials (VC — Justificatifs vérifiables), également normalisés au W3C — Verifiable Credentials Data Model v2.0 (Recommandation, 15 mai 2025). Un VC est un ensemble d’assertions signées (ex. « cette personne possède tel diplôme »), émis par une autorité (université, administration) à destination d’un titulaire, qui peut ensuite présenter ces preuves à un vérificateur — sans exposer plus d’information que nécessaire (sélective disclosure), et avec des mécanismes de révocation/expiration. L’émetteur et le vérificateur peuvent chacun être identifiés par des DIDs. Ensemble, DIDs + VC visent une promesse : sécurité, décentralisation, et — via des alias locaux — un certain confort humain. (W3C) Où gagne-t-on par rapport au triangle ? Sécurité : l’authenticité se prouve par cryptographie (signatures, preuves), et la rotation de clés limite l’usurpation durable. Pas besoin d’un certificat X.509 adossé à une CA géante ; on peut vérifier à la volée via le DID Document. (W3C) Décentralisation : pas de racine unique ; chaque méthode DID (did:key, did:web, did:ion, etc.) définit son substrat (du simple fichier HTTPS aux ancrages sur des réseaux distribués). On substitue une fédération de méthodes à la pyramide DNS/ICANN. (W3C) Humain-mental (partiel) : un DID n’est pas, en soi, mémorisable. Mais on peut lier un DID à un alias local (carte de contacts, carnet d’adresses, UI du portefeuille d’identité). L’humain ne retient plus la clé, il retient un nom de relation (petname). Zooko n’est pas nié ; on déplace l’exigence d’humanité vers la couche d’interface. (Wikipédie) Où le triangle continue de mordre Lisibilité globale : si chaque communauté maintient ses alias, le conflit de noms ressurgit à l’échelle globale (deux « @alice » pointant sur deux DIDs différents). Les DIDs n’éliminent pas le problème social d’arbitrage des noms rares ; ils le déplacent. (Wikipédie) Gouvernance de méthodes : la méthode DID est un point de confiance (qui maintient la chaîne, le registre, le fichier HTTPS ?). On troque la racine unique contre des racines multiples — il faut auditer les méthodes. (W3C) Expérience utilisateur : sans bons alias, l’humain reste face à des chaînes opaques. Les projets de noms « blockchain » (ENS, etc.) offrent des alias globaux, mais réimportent captation spéculative et litiges. (arXiv) En pratique, le paquet DID + VC + UI de petnames/contacts permet un compromis robuste pour ma série « Vrai nom » : on garde des noms opératoires (DIDs) découplés des personnes civiles, on atteste des attributs via des preuves révoquables, et l’on retrouve, côté humain, le nom vécu (alias de relation). Autrement dit : on sépare, enfin, nom qui agit et nom qui parle. À quoi cela sert-il pour tes thèmes (golem / EMET→MET / gestes d’arrêt) ? Geste d’arrêt : un VC peut être révoqué, un DID roté — équivalents techniques de MET (désactivation) plutôt que de la lettre magique. Ici, l’arrêt est procédural, journalisé, auditables. (W3C) Réduction de surface : au lieu d’user du nom-civil (exposé, indexable), on présente un VC minimal (« +18 ans », « membre de X ») sans livrer plus — moindre emprise des « golems de papier ». (W3C) Traçabilité maîtrisée : par séparation des rôles (émetteur / titulaire / vérificateur), on limite les corrélations sauvages. Là encore, le pouvoir ne disparaît pas ; il devient conditionné. Et les systèmes « tout-en-un » (ENS, Namecoin, Handshake) ? Ils fournissent des alias globaux (lisibles), ancrés sur des chaînes publiques. Ils « semblent » battre le triangle : lisibles et décentralisés et sécurisés. En pratique, ils obtiennent le trio au prix d’autres contraintes : gouvernance (qui tranche les collisions ?), inégalités d’allocation (accaparement précoce), et interopérabilité (hors DNS). Les études académiques sur ENS ou Namecoin confirment ces déplacements : on gagne en résilience, on perd en médiation institutionnelle. (arXiv) Encadré — Schéma minimal (triangle de Zooko, en texte) Humain-mental (mémorisable) /\ / \ / \ Sécure /______\ Décentralisé (anti- limites (sans racine usurp.) de Zooko) unique) Exemples rapides : DNS/DNSSEC → Humain + Sécure, pas Décentralisé. Adresses .onion / clés → Sécure + Décentralisé, pas Humain. DIDs + alias locaux → Sécure + Décentralisé nativement ; Humain via UI de relation (petnames). (Wikipédie) Encadré — Ce que les DIDs résolvent / ne résolvent pas Résolvent Vérification sans registre central (documents DID). (W3C) Rotation / révocation d’identifiants sans changer de « personne ». (W3C) Lien avec des preuves (VC 2.0) minimisant l’exfiltration de données. (W3C) Ne résolvent pas Conflits de noms lisibles à l’échelle globale (si on veut un « @alice » mondial). (Wikipédie) Gouvernance des méthodes (qui garde le substrat sain ?). (W3C) Ergonomie sans UI de qualité (sinon chaînes opaques). Lexique (réutilisable) Zooko’s Triangle — Triangle de Zooko : trilemme noms humain-mentaux / sécurisés / décentralisés (choisir deux). (Wikipédie) DID (Decentralized Identifier) — Identifiant décentralisé : identifiant vérifiable dont la résolution ne dépend pas d’une autorité centrale ; spécifié par le W3C DID v1.0. (W3C) DID Document : document associant au DID des clés, services et règles de mise à jour. (W3C) VC (Verifiable Credential) — Justificatif vérifiable : attestation signée (émetteur → titulaire → vérificateur), modèle W3C VCDM 2.0. (W3C) Petname — Nom de relation : alias local attribué par l’utilisateur (lisibilité sans prétention globale). (Wikipédie) À retenir (pour la série « Vrai nom ») Le triangle ne disparaît pas : on relocalise la contrainte. Les DIDs donnent des noms opératoires robustes ; les VC apportent des preuves révoquables ; l’interface fournit les noms vécus. Le pouvoir ne s’évanouit pas : il devient procédurel, auditable, révocable. Autrement dit : un cadre où nommer n’expose pas fatalement — à condition de garder la main sur qui résout quoi, avec quelles preuves, jusqu’à quand. Sources clés Triangle de Zooko — présentation & typologie (exemples DNS, .onion, Bitcoin). (Wikipédie) W3C — Decentralized Identifiers (DID) v1.0 — Recommandation (19 juillet 2022). (W3C) W3C — Verifiable Credentials Data Model v2.0 — Recommandation (15 mai 2025) + historique. (W3C) Analyse académique ENS / Namecoin (forces/limites, « solution au triangle » revendiquée). (arXiv) Sommaire de la série 1. Nommer pour habiliter — Le Guin (Earthsea — Terremer) 2. Nommer pour prendre — Isis & Rê (Papyrus de Turin) 3. Nommer pour délier — Rumpelstiltskin (ATU 500) 4. Noms à l’ère réseau — Vernor Vinge 5.Argile et algorithmes — à Propos du Golem 6. Qui tient le dictionnaire des noms ? — Triangle de Zooko Voir tous les épisodes (page du mot-clé)|couper{180}